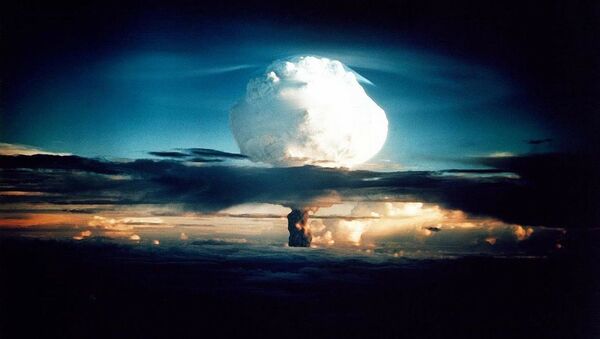

СУХУМ, 2 сен — Sputnik. Бывший заместитель министра обороны США Роберт Уорк считает, что использование военными систем искусственного интеллекта при принятии решения о нанесении ядерного удара таит в себе серьезную опасность, передает РИА Новости со ссылкой на издание Breaking Defense.

По мнению Уорка, не исключены ситуации, в которых искусственный интеллект может расценить неопасные факторы как представляющие угрозу, и это является "тревожной перспективой".

Бывший заместитель министра обороны США привел в пример российскую систему "Периметр", которая может принять сейсмическую активность за ядерные взрывы, после чего направит запрос в штаб войск, и если вдруг не получит ответа, может отдать команду на запуск межконтинентальных баллистических ракет.

Уорк также обратил внимание на то, что военное применение искусственного интеллекта может привести к плачевным последствиям и без его прямого участия в управлении ядерным оружием. В частности, такой сферой может быть его использование при анализе разведывательных данных, а также в системах раннего предупреждения.

"Представьте, система искусственного интеллекта в командном центре китайских войск, проанализировав оперативные данные, заявляет, что США готовятся нанести удар по Китаю и рекомендует нанести превентивный удар", — сказал Уорк.

Тем не менее, он отмечает, что искусственный интеллект несомненно может принести пользу для военных, однако его применение должно быть ограничено, и не должно распространяться на ядерное вооружение, поскольку это может привести к "катастрофическому сценарию".

Читайте также:

- Мрак и холод: названы последствия ядерной войны между Россией и США

- Спасти человечество: составлен список основных угроз жизни на Земле

- Еще думают: Москва ожидает от Вашингтона заявления о недопустимости ядерной войны